在我们武术界,有这样一句话:“天下武功出少林”,这句话主要是用来说明少林寺在武术界天下至尊的地位,自从达摩祖师自创了罗汉拳以后,什么易筋经啊,铁步衫啊,都是我们少林寺的武功。每个人练的都不同,我作为少林寺俗家弟子,练的是少林七十二绝学之一的童子功,从我出生到上大学,我有17年的练功经历,可惜一上大学,童子功就被一位武学女前辈给破了,她练的是葵花宝典。现在多少年过去了,我发现并不止“天下武功出少林”,天下的科技也是出自少林,当年洋人的公司Facebook搞元宇宙,我少林寺的扫地僧瞬间搞出了“栾生少林”元宇宙。现在又是OpenAI搞ChatGPT,听说我少林寺的另一个研发扫地僧机器人的扫地僧搞了一个“文心一言”的ChatGPT,不用问,技术肯定不输洋人。我为少林寺感到骄傲,情人节已过,我打算重新拾起我荒弃多年的童子功,先从童子拜观音开始练起。

从少林寺的操作,我们可以清晰明了的得知,ChatGPT是真的火了。当然了,除了少林寺,国内至少还有50家公司宣称这事他们一直在搞,秘而不宣而已,让我们拭目以待吧!

上一期,我讲我要研究一下OpenAI公司发布的论文,这几天我抽空就读这篇论文,然后发现,只读这一篇论文是不行的,OpenAI发布论文的方法是,阶段性的出点成果,然后发一篇。比如说现在ChatGPT已经到了ChatGPT4了,但是论文还停留在InstructGPT的状态。要读懂这篇《Training language models to follow instructions with human feedback》的论文,还是需要读前期的论文,因为ChatGPT的论文,连贯性很强,要读这一篇,又需要读前面的东西,我现在还没读完,我只能边读边理解,当个二手科学家录个电台讲讲其原理,尽量做到不忽悠大家,毕竟,我只是俗家弟子,道行不深。

看论文先看作者,一大堆,有些有星号,有些没星号,有些还有奇怪的符号。一般来说,咱们看到的论文作者是没有星号的,按照论文作者的贡献来排名,第一作者贡献80%,第二作者贡献15%,第三作者贡献5%,第四作者挂个名……这个主要看你导师的人品了。但是有星号的呢,基本上就是说,作者虽然很多,但是呢,这些带星号的人,对该论文的贡献是一样的。Google曾经发了一篇众所周知大名鼎鼎的论文叫《Attention is all your need》,这篇论文非常的重要,如果你是搞机器学习,机器翻译的话,肯定要读这一篇论文的,这篇论文所有的作者都加了星号,说明所有人的贡献是一样大的。再来说这篇论文,大家可以按照论文的作者,一个一个的Google,你就会找到这些人,有些已经出走了,出走以后,就成立了OpenAI的竞争对手,也是上一期讲的那个Anthropic公司,其中就有论文的作者Amanda Askell,Paul Christiano。这篇论文还有一个亮点是竟然有两个领导,Jan Leike,Ryan Lowe。一般来说,有两个领导,一山不容二虎,那到底听谁的呢?

看完了论文的题目,再看作者,不是我势力眼,如果你看一篇论文的作者,不出名,大概率这篇论文不怎么样,因为每天这个世界上发表成千上万份论文,我们当然是读不完的,如果一个作者是什么小人物,所供职的地方又是个不知名的小地方,那这篇论文是不是值得读大家要有点考虑了。论文不像是散文,也不是小说,论文是更像八股文,你不能乱来的,其结构是固定的。我可以教大家一点论文阅读小常识,先看题目你感兴趣么,再看作者,然后看摘要,中间的部分不看,直接到最后看结论。标题,作者,摘要和结论,非常的短,你用个10分钟就可以了,看看他说了个啥,摘要是提出一两个问题,结论是他有没有解决这一两个问题。你就能知道对这个论文你感不感兴趣,如果你感兴趣,再回过头来读。

如果你感兴趣,那就再看论文的介绍部分,方法部分和实验部分。如果你不想重复实验,就不用管那些公式什么的,那都是细节,没必要知道,你相信就好。对科学家来说,实验能否重复很重要,比如中国前几年出过一系列丑闻,实验不可重复,每做一次实验花人家10几万美元,最后几百个实验室试图重复,没搞定,最后中国这边撤稿了,生物DNA方面的,大家一定要小心,在国内做假没什么,在国际上搞一次,彻底玩蛋。如果你不搞实验,看看就好,主要是看看介绍和方法。如果你特别感兴趣,事关你的饭碗或者毕业证,跟你十分相关,那就要细读了,不但每个字都要读,连参考文献也要读才可以,这种就不在我们普通人的讨论范围了。我读的大部分论文都是花20分钟的那种,只有读一些RFC什么的,那才会仔细读。

还有一点提醒想搞研究的听众,如果你想出名,出名非常重要,在你写论文的时候,一定要给自己的模型起个名字,这非常重要,因为这个模型如果一下子火了,那你的名声就跟他挂在一起了。比如OpenAI给自己的模型起的名字叫ChatGPT。《Attention is all your need》这个模型的名字叫Transformer,变形金刚,其实这个名字有点危险,因为别人搜索的时候,可能出来的是电影Transformer。如果不给自己的模型起名,可能对很多作者是非常不公平的,就像是掀起了深度学习浪潮的一篇论文,名字叫《ImageNet Classification with Deep Convolutional Neural Networks》,这篇论文发表于2012年吧,当时这几位在加拿大多伦多大学的教授可能没想到自己的研究会挨这么多骂,是的,这篇论文发表以后,曾经引起了巨大的争议。这三位作者没有给自己的模型起个名字,于是大家就用第一作者的名字来命名了,名字叫AlexNet。这篇论文非常重要,如果你也是个有点科技梦的出租车司机,希望你找来读一下。

再来说起名,中国其实很早就对标了ChatGPT,早就在2020年的时候,中国举国之力搞了一个悟道,号称比ChatGPT 3的参数要牛逼10倍。名字很重要,孙悟空,猪悟能,沙悟净,这里又出了一个悟道。这个悟道出不不少东西,其中有一个叫悟能作诗。

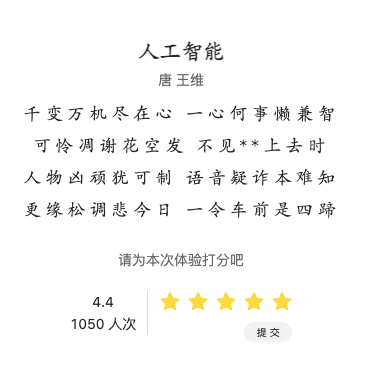

千变万机尽在心,一心何事懒兼智。可怜凋谢花空发,不见**上去时。 人物凶顽犹可制,语音疑诈本难知。更缘松调悲今日,一令车前是四蹄。

我一看,我去,竟然有两个星号,这是碰到敏感词了么?其实在中国做人工智能挺难的,既要让人工智能学会讲话,又要让人工智能学会不讲话,比美国要难啊!

有**才有中国味。

还有能进的QQ群没,想进个群摸鱼聊天!

都被封了